注目の自動車ニュース

「ちょっと右曲がって」音声・視線・ジェスチャで制御する自動運転車、名古屋大学などが開発

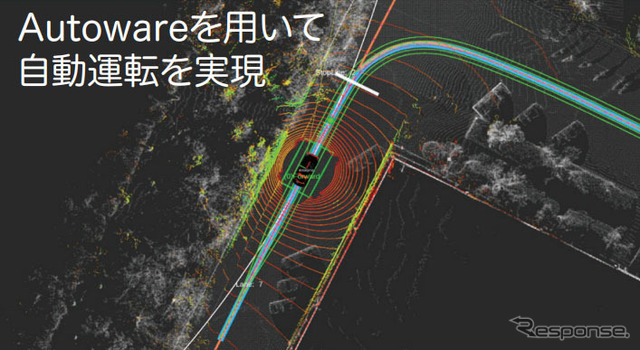

名古屋大学は10月25日、徳島大学、アイシン精機との共同で、音声・視線・ジェスチャを用いて操作するマルチモーダル対話型自動運転車を世界で初めて開発したと発表した。

近年、自動運転車の研究開発は加速。しかし、周囲のセンシングや車両制御などの技術は進展しているものの、どのように自動運転車を操作するかについての検討は不足している。研究グループでは、自動運転車の理想的なインタフェースとしてタクシーをイメージ。運転手に行き先を告げ、必要に応じて曲がる場所などを伝え、行き先に来たら停まってもらう。音声による対話を中心に、ジェスチャなどを交えながら交わすタクシーでのやり取りを自動運転車との間でできないかを検討してきた。

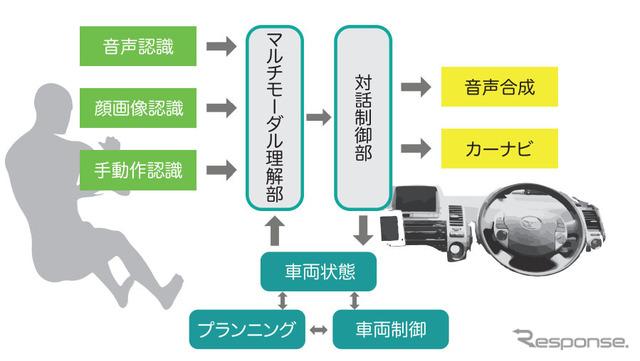

自動運転車用マルチモーダルインタフェースシステムは、人(ユーザ)の音声、ジェスチヤ、視線などはそれぞれ音声認識、深度センサ、映像処理を用いて認識。例えばユーザが「右に曲がって」と発声あるいは指差しすれば、ユーザの意図に従って、自動車を右に曲がるように制御する。一方、音声とジェスチャや視線を同時に用いる場合は、各入力手段(モダリティ)の時間的関係も考慮しながら、マルチモーダル理解を行い、車を制御する。

今後、自動運転も含めて様々な車載機器の操作を容易に行うための一つの方向性として、こうしたマルチモーダルインタフェースが進展することが考えらる。研究グループでは自動運転車に限らず、機械と人間の協調・共生を考えた場合に、マルチモーダルインタフェースは自然で使いやすいインタフェースとして、取り入れられていくだろうと期待を述べている。